データ活用が企業競争力の要となる現代のビジネス環境において、社内に散在するデータの統合と活用は多くの企業が直面する課題です。特に複数のシステムから生成される多様なデータを効率的に収集・変換・格納するためには、適切なETL(Extract, Transform, Load)の仕組みが不可欠です。

しかし、ETLツールの導入には「どのツールを選ぶべきか」「導入コストに見合うリターンがあるのか」「専門知識の少ないチームでも運用できるのか」といった疑問や不安が付きまといます。特に中堅企業のIT部門では、限られたリソースの中でデータ活用基盤を構築する必要があるため、正しい選択と効果的な導入プロセスが成功の鍵を握ります。

本記事では、ETLの基本概念からDWH(データウェアハウス)との違い、代表的なETLツールの特徴、そして導入から運用までの実践ステップまで徹底解説します。また、業種や目的別の導入事例や、運用時の課題と対処法についても詳しく紹介します。

目次

1. ETLとは?基礎知識と役割

ETL(Extract/Transform/Load)とは、異なるシステムやデータソースからデータを抽出し、加工して、目的の場所に格納する一連のプロセスを指します。ビジネスにおけるデータ活用の重要性が高まる中、ETLはデータ統合の基盤技術として注目を集めています。

ETLの名称は、その主要な3つのプロセスの頭文字から来ています。まず「Extract(抽出)」では、社内の基幹システムやクラウドサービス、外部データなどさまざまな場所に点在するデータを収集します。次に「Transform(変換)」では、収集したデータを分析しやすい形に整形・加工します。最後に「Load(ロード)」では、加工したデータをデータウェアハウスやデータマートなどの保存先に格納します。

企業が抱える課題として、システムごとにデータが分断されていることが挙げられます。例えば販売データは販売管理システムに、顧客データはCRMに、在庫データは在庫管理システムにあるという状況です。これらを結合して分析するには膨大な手作業が必要でした。ETLはこの課題を解決し、データの一元管理と効率的な分析基盤の構築を可能にします。

現代のビジネス環境では、迅速かつ正確なデータ分析に基づく意思決定が競争力の源泉となっています。ETLは単なるデータ移行ツールではなく、企業のデータ戦略を支える重要なインフラストラクチャです。

1-1. ETLの概要と具体的な処理プロセス

ETLの各プロセスについて、より具体的に見ていきましょう。

まず「Extract(抽出)」フェーズでは、多様なデータソースから必要なデータを選択的に収集します。データソースには、関係データベース(MySQL、Oracle、SQLServerなど)、NoSQLデータベース、Excelファイル、CSVファイル、APIを通じたWebサービスなどさまざまな形式があります。異なるフォーマットやプロトコルに対応する能力がETLツールの重要な機能です。

次に「Transform(変換)」フェーズでは、収集したデータに対してさまざまな処理を行います。具体的には以下のような変換処理が一般的です。

- データ型の変換(文字列を日付型に変換するなど)

- データのフィルタリング(不要なレコードの除外)

- データのクレンジング(欠損値や誤ったデータの修正)

- データの集計(合計、平均、最大値の計算など)

- データの結合(複数のテーブルやファイルの結合)

- ビジネスルールの適用(特定の計算式の適用など)

最後に「Load(ロード)」フェーズでは、変換されたデータを目的の保存先に書き込みます。この保存先は通常、分析用に最適化されたデータウェアハウスやデータマートです。ロードの方式には、全データを一度に置き換える「フルロード」と、変更があったデータのみを更新する「増分ロード」があります。

ETLの処理はバッチ処理として定期的に(日次、週次など)実行されるケースが多いですが、最近ではリアルタイムETLの需要も高まっています。リアルタイムETLでは、データの発生とほぼ同時に抽出・変換・ロードが行われ、よりタイムリーな分析を可能にします。

1-2. ETLが企業にもたらすメリット

ETLを導入することで、企業はさまざまなメリットを享受できます。まず最大の利点はデータ統合による包括的な分析が可能になることです。例えば、販売データと顧客データを統合することで「どの顧客層がどの商品を好んで購入しているか」といった多角的な分析が容易になります。これにより、より精度の高いマーケティング戦略や商品開発が可能になります。

次に、データ品質の向上も重要なメリットです。ETLプロセスの中で、データクレンジングやバリデーションを行うことで、不整合や欠損のあるデータを検出・修正できます。高品質なデータは信頼性の高い分析結果につながり、誤った意思決定のリスクを低減します。

| ETL導入のメリット | 内容 |

|---|---|

| 業務効率化 | データ収集・加工の自動化により、手作業が削減される |

| 意思決定の迅速化 | 必要なデータがタイムリーに提供されるため、判断が素早くなる |

| コスト削減 | 手作業や個別システム開発のコストが削減される |

| データガバナンス強化 | データの流れが可視化され、管理が容易になる |

| スケーラビリティ向上 | データ量の増加にも柔軟に対応できる |

また、ETLによる業務プロセスの自動化も見逃せない利点です。以前は手作業で行っていたデータ収集や加工作業が自動化されることで、担当者の作業負荷が大幅に軽減されます。解放された時間をより創造的な業務や戦略的な分析に充てることができるようになります。

さらに、ETLツールはデータのトレーサビリティを確保します。いつ、どのデータが、どのように処理されたかの記録が残るため、問題が発生した際の原因究明や監査対応が容易になります。特に金融業界など厳格なコンプライアンスが求められる業種では、この特性は非常に価値があります。

2. ETLとDWH(データウェアハウス)の違い

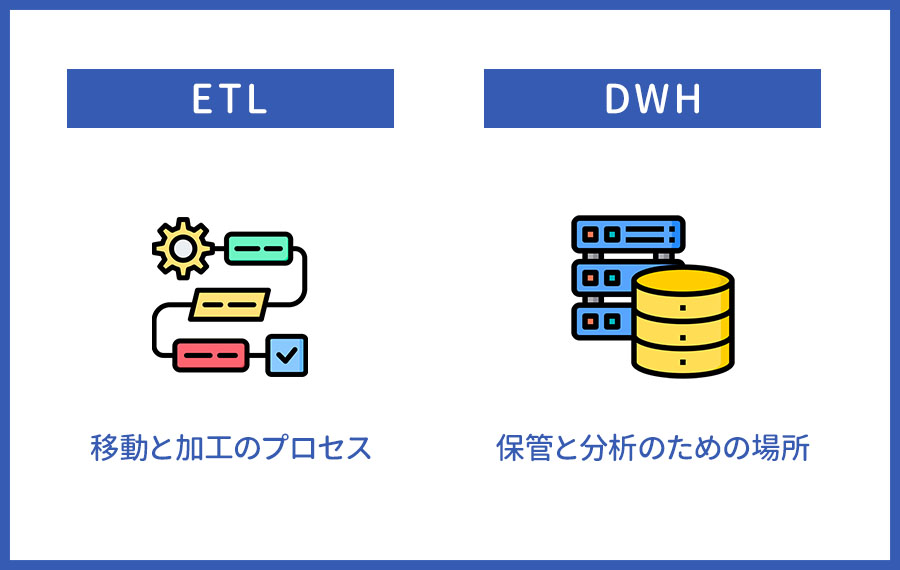

ETL(Extract, Transform, Load)とDWH(データウェアハウス)は、企業のデータ活用において重要な役割を担っています。この2つは密接に関連しながらも、明確に異なる機能を持っています。ETLはデータの「移動と加工のプロセス」を指し、DWHはデータの「保管と分析のための場所」を指します。

ETLはデータを元のシステムから抽出し、必要な形に変換してから、目的の場所に格納するまでの一連の流れです。例えば、販売システム、顧客管理システム、在庫管理システムなど、社内に散在するさまざまなデータソースから情報を集め、統一された形式に整えて分析しやすくします。

一方、DWHはこれらの処理済みデータを格納するための大規模なデータベースシステムです。DWHの主な特徴は、データの一元管理と長期保存、そして高速な分析クエリの実行が可能な点にあります。

両者の最大の違いは「プロセス」と「場所」という点です。ETLがデータの流れや変換を担当するのに対し、DWHはそのデータが最終的に落ち着く先であり、ビジネスインテリジェンス活動の基盤となります。データ分析基盤を構築する際には、この違いを理解した上で、ETLとDWHを適切に組み合わせることが重要です。

2-1. ETLとDWHのそれぞれの役割と目的

ETLとDWHは、企業のデータ活用戦略において相互補完的な関係にあり、それぞれが独自の役割と目的を持っています。

ETLの役割と目的は、多様なソースからのデータ統合と品質確保です。具体的には、異なるシステムやフォーマットのデータを抽出し(Extract)、ビジネスルールに基づいて変換・クレンジングを行い(Transform)、分析に適した形でDWHなどに格納する(Load)という一連の作業を担います。ETLの主要な目的は、データの一貫性と正確性を確保すること、そして分析に適した形式にデータを準備することです。

一方、DWHの役割と目的は、意思決定をサポートするための統合データリポジトリを提供することです。DWHは主に以下の特性を持ちます。

- 主題指向:特定のビジネストピックに関連するデータを整理

- 統合:複数のソースからのデータを一貫したフォーマットで保持

- 時系列:長期間にわたるデータの履歴を保持

- 不変:一度格納されたデータは通常変更されない

DWHは経営層やアナリストがデータドリブンな意思決定を行うための基盤となり、レポート作成、傾向分析、予測モデリングなどのビジネスインテリジェンス活動を支えています。

ETLがデータを「準備する」プロセスであるのに対し、DWHはそのデータを「活用する」ための環境を提供すると言えるでしょう。両者は密接に連携し、企業のデータ資産を最大限に活用するためのエコシステムを形成しています。

2-2. ETLとDWHを連携させる際の注意点

ETLとDWHを効果的に連携させることは、データ分析基盤構築の成功において重要です。しかし、この統合プロセスにはいくつかの注意点があります。

まず、データモデリングの整合性を確保することが必須です。ETLで変換するデータ構造とDWHのデータモデルが適切に設計・連携されていないと、せっかく抽出・変換したデータが分析に活用できない事態に陥ります。事前にDWHのスキーマ設計を十分に検討し、ETLプロセスでどのような変換が必要かを明確にしておくことが重要です。

パフォーマンスの問題にも注意が必要です。ETL処理は大量のデータを扱うため、処理時間が長くなりがちです。特に、DWHへのロード中はシステムリソースを大量に消費するため、ビジネスユーザーの分析作業に影響を与える可能性があります。この問題を回避するためには、ETL処理のスケジューリングを業務時間外に設定したり、増分ロードを採用したりする工夫が効果的です。

データ品質の管理も連携成功の鍵となります。ETLプロセスでは、以下のような要素に注意してデータクレンジングを行う必要があります。

- 重複データの排除

- 欠損値の適切な処理

- 型変換時のエラー処理

- コード値やマスタデータの統一

さらに、拡張性と柔軟性を考慮した設計も重要です。ビジネス要件は常に変化するため、新しいデータソースの追加やデータモデルの変更に柔軟に対応できるアーキテクチャを採用すべきです。また、ETLプロセスの監視と管理も欠かせません。処理の成功/失敗を監視し、エラー発生時には適切に通知・対応できる仕組みを整えることで、データの信頼性を確保できます。

これらの注意点に適切に対処することで、ETLとDWHの連携がスムーズに進み、企業のデータ活用能力を大きく向上させることができるでしょう。

3. ETLツールの役割と具体的な機能

ETLツールはデータ統合の中心的存在として、企業が保有する膨大で多様なデータを効果的に活用するための要となります。多くの企業では、販売管理システム、CRM、ECサイトなど複数のデータソースが存在し、それらのデータを統合して分析に役立てるプロセスが必要です。ETLツールはこのデータ統合プロセスを自動化し、効率化する重要な役割を果たしています。

ETLツールの主要な機能は、その名称が示す通り「Extract(抽出)」「Transform(変換)」「Load(ロード)」の3つのプロセスを一元的に管理することです。さまざまなソースからデータを収集し、ビジネスニーズに合わせてデータを加工し、最終的にデータウェアハウスやデータマートに格納します。これにより、散在していたデータが分析可能な形で一箇所に集約されます。

現代のビジネス環境において、データドリブンな意思決定の重要性は高まる一方です。ETLツールはこの要求に応える形で、リアルタイムデータ処理やデータ品質管理など高度な機能を提供するように進化しています。特に近年は、クラウドベースのETLソリューションが普及し、より柔軟でスケーラブルなデータ統合が可能になりました。

企業のIT部門責任者としては、ETLツールの導入によってデータ活用の基盤を確立し、経営層にデータに基づく提案ができるようになります。また、データ分析の前段階である「データの準備」にかかる工数を大幅に削減できるため、分析業務の効率化にも直結します。

3-1. ETLツールが果たす役割と必要性

現代企業におけるETLツールの必要性は、ビジネスデータの爆発的な増加と多様化に直接関連しています。企業は今や、従来の構造化データだけでなく、非構造化データや半構造化データなどさまざまな形式のデータを扱う必要があります。ETLツールはこれらの異なるデータ形式を統一的に処理し、分析可能な形式に変換する重要な橋渡し役となっています。

ETLツールの最も基本的な役割は、データ統合プロセスの自動化です。かつては手作業やカスタムコーディングで行われていたデータ統合作業を、視覚的なインターフェースを通じて設計・実行できるようにします。これにより、IT部門のプログラマーだけでなく、ビジネス側のアナリストも直接データ処理のワークフローを構築できるようになります。

また、ETLツールはデータ品質の確保においても重要な役割を果たします。データの抽出から変換、ロードの各プロセスにおいて、データクレンジングやデータの正規化、重複排除などの処理を行うことで、最終的な分析結果の信頼性を高めます。特にビジネスの意思決定に直結するデータ分析においては、この品質管理の側面が重要です。

さらに、現代のETLツールはデータガバナンスをサポートする機能も備えています。データの変更履歴を追跡するログ機能や、セキュリティ管理、コンプライアンス対応など、企業のデータ管理ポリシーに沿ったデータ処理を実現します。これらの機能は、特に厳格なデータ保護規制が存在する業界において重要視されています。

多様なデータソースを持つ企業においては、ETLツールの導入が戦略的なデータ活用の第一歩となります。データサイロを解消し、全社的なデータの可視化と分析を可能にすることで、より迅速で正確な意思決定を支援できます。

3-2. 代表的なETLツールの製品と特徴

ETLツール市場は近年急速に拡大しており、各ベンダーが独自の強みを持つ製品を展開しています。企業のニーズや規模、予算に応じて最適なETLツールを選定するためには、代表的な製品の特徴を理解することが重要です。ここでは市場で評価の高いETLツールをいくつか紹介します。

Talend Data Integrationは、オープンソースベースのETLツールとして広く知られています。直感的なビジュアルデザイナーを提供し、コーディング不要で複雑なデータ統合プロセスを構築できる点が特徴です。また、900以上のコネクタを提供しており、ほぼすべての主要データソースとの接続が可能です。中小企業から大企業まで幅広い規模の組織に対応できるスケーラビリティも魅力の1つです。

Informatica PowerCenterは、エンタープライズレベルのデータ統合に強みを持つ製品です。高度なデータ品質管理機能やメタデータ管理機能を備え、大規模な企業データの統合に適しています。特に金融や医療など、厳格なデータガバナンスが求められる業界での導入実績が豊富です。

DataSpiderは、日本企業においても広く採用されている純国産のデータ連携・ETLツールです。コード不要で直感的なインターフェースを備え、国内企業特有のレガシーシステムとの親和性が高いことが特徴です。また、国産ツールならではの手厚い日本語サポートがあり、初めてのETL導入や運用に不安を抱える企業にも適しています。

| ETLツール名 | 主な特徴 | 適している企業規模 | 価格帯 |

|---|---|---|---|

| Talend Data Integration | オープンソースベース、視覚的インターフェース | 中小〜大企業 | 中〜高 |

| Informatica PowerCenter | 高度なデータ品質管理、堅牢性 | 大企業 | 高 |

| Microsoft SSIS | SQLサーバーとの親和性、コスト効率 | 中小企業 | 低〜中 |

| AWS Glue | クラウドネイティブ、サーバーレス | クラウド志向の企業 | 従量課金 |

| Matillion | クラウドデータウェアハウス特化 | データドリブン企業 | 中 |

| DataSpider | 国産ツール、日本語サポート、レガシー対応力 | 中小〜大企業 | 中 |

クラウド環境への移行が進む中、AWS GlueやMatillionなどのクラウドネイティブなETLツールも人気を集めています。これらのツールは、従来型のオンプレミスETLツールと比較して、インフラ管理の手間が少なく、スケーラビリティにも優れています。特にAWS Glueはサーバーレスアーキテクチャを採用しており、必要に応じて自動でリソースを拡張・縮小する柔軟性があります。

ETLツール選定においては、自社のデータ環境や技術スタック、予算、そして将来のデータ戦略との整合性を考慮することが重要です。特に、既存システムとの連携のしやすさやユーザーインターフェースの使いやすさ、サポート体制などの実用面も含めて総合的に評価することをお勧めします。

4. ETLツールの導入を成功させるステップ

データ活用の重要性が高まる中、ETLツールの導入は多くの企業にとって避けて通れない道となっています。しかし、闇雲に導入を進めるのではなく、計画的なステップを踏むことが成功への鍵です。まず第一に、現状の業務フローやデータの流れを詳細に分析し、どのような課題を解決したいのかを明確にしましょう。次に、プロジェクト全体のスケジュールを立て、予算や人員配置を決定します。

ETLツール導入においては、短期的な効果だけでなく長期的な運用も見据える必要があります。特に、将来的なデータ量の増加やシステム連携の拡張性を考慮することが重要です。また、導入後の運用体制や教育計画も事前に策定しておくことで、スムーズな移行が可能となります。

IT部門だけでなく、実際にデータを活用するビジネス部門も巻き込んだプロジェクト体制を構築することも成功の秘訣です。部門間のニーズを吸い上げ、全社的な視点でETLツールの活用方法を検討することで、導入効果を最大化できます。特に中堅企業では、限られたリソースで効果を出すため、この点を意識した導入ステップを踏むことが求められます。

4-1. ETLツール選定時に確認するべきポイント

ETLツールを選ぶ際には、いくつかの重要なポイントを押さえておく必要があります。まず、データソースとの連携性を確認しましょう。自社で利用している基幹システムやクラウドサービス、各種データベースとスムーズに連携できるかどうかは導入成功の鍵となります。特に今後追加される可能性のあるデータソースへの対応も視野に入れておくとよいでしょう。

次に重視したいのはユーザーインターフェースの使いやすさです。専門知識が少ないチームメンバーでも直感的に操作できるGUIを備えているか、ドラッグ&ドロップでデータフローを設計できるかなどをチェックします。これにより、運用フェーズでの工数削減やエラー防止につながります。

スケーラビリティとパフォーマンスも重要な選定ポイントです。将来的なデータ量の増加に耐えられるか、処理速度は十分かを確認しましょう。また、自動化機能の充実度も見逃せません。定期的なETL処理のスケジュール実行や、エラー発生時の通知機能なども確認すべきです。

| 選定ポイント | 確認事項 |

|---|---|

| 連携性 | 既存システムとの接続性、API対応状況 |

| 操作性 | GUI操作の直感性、ノンプログラミング対応 |

| 拡張性 | データ量増加への対応、新データソース追加の容易さ |

| サポート体制 | 導入支援、トレーニング、技術サポートの充実度 |

| コスト | 初期費用、ランニングコスト、ROI |

さらに、セキュリティ機能についても忘れずに確認しましょう。データアクセス権限の設定や監査ログの取得など、重要な情報を扱う上で必須の機能が実装されているかどうかはビジネス要件を満たす上で不可欠です。

4-2. ETLツール導入から運用までの流れと留意点

ETLツール導入から運用までのプロセスは、大きく計画・導入・運用の3フェーズに分けられます。計画フェーズでは、要件定義を綿密に行い、どのようなデータをどのように処理したいのかを明確にします。この段階で曖昧な部分を残さないことが、後のトラブルを防ぐ鍵となります。また、導入によって得られる効果を数値化し、ROI(投資対効果)を算出しておくことで、経営層への説明資料としても活用できます。

導入フェーズでは、データマッピングやトランスフォーメーションルールの設計に十分な時間をかけることで、後の修正コストを削減できます。また、テスト環境での検証を念入りに行い、本番環境に移行する前に問題点を洗い出しておきましょう。

運用フェーズに入ったら、定期的なパフォーマンス監視とプロセスの最適化が欠かせません。ETL処理の実行時間や失敗率などの指標を継続的に計測し、ボトルネックがないか確認します。また、ビジネス要件の変化に合わせて、ETLプロセスも柔軟に見直していくことが重要です。

- ETL導入前に実施すべき準備作業

- 導入プロジェクトの体制と役割分担の決定方法

- データマッピングとトランスフォーメーションルールの設計手法

- テスト環境と本番環境の切り替え手順

- 運用マニュアルと教育資料の整備方法

さらに、知識移転とドキュメント整備にも力を入れましょう。担当者が異動や退職で変わっても運用が滞らないよう、操作手順やトラブルシューティングのマニュアルを整備しておくことが、長期的な運用成功の秘訣です。定期的な内部勉強会の開催も効果的です。

5. ETLの導入が効果的なケース

ビッグデータ時代において、企業が持つデータ資産の価値を最大限に引き出すためには、効率的なデータ統合と管理が不可欠です。ETL(Extract, Transform, Load)ツールの導入は、多くのビジネスシーンで大きな効果を発揮します。特に、複数システムからのデータ統合が必要な場合や、日々のデータ処理業務に多くの工数がかかっている組織にとって、ETL導入は解決策となるでしょう。

ETLが効果的なケースとして、まず挙げられるのが複数のデータソースを持つ企業です。販売管理システム、CRM、マーケティングツールなど、さまざまなシステムから生成されるデータを一元管理することで、包括的な分析が可能になります。また、定期的なレポート作成作業に時間を費やしている企業も、ETL導入による自動化で大幅な業務効率化が見込めます。

データ品質の向上を目指す場合も、ETLは強力な味方となります。データの抽出から変換、格納までの一連のプロセスを標準化することで、一貫したデータ品質管理が実現できます。さらに、業界規制やコンプライアンス対応のためのデータ管理体制構築にも、ETLツールの導入は有効です。

特に中堅・大企業では、部門ごとに異なるシステムを利用していることが多く、それらのデータを統合して経営判断に活用するためのインフラとしてETLが重要な役割を果たします。導入を検討する際は、自社のデータ環境や課題を明確にし、最適なソリューションを選定することがポイントです。

5-1. データ統合・一元管理でのETL活用事例

多くの企業では、業務システムの発展とともにデータは分散化し、全社的な視点でのデータ活用が困難になっています。ETLツールを用いたデータ統合・一元管理は、この課題を解決する有効なアプローチです。具体的な活用事例を見ていきましょう。

ある小売チェーンでは、店舗ごとのPOSシステム、オンラインショップの受注システム、倉庫管理システムなど複数のデータソースが存在していました。これらをETLツールで統合することにより、全チャネルの販売データを一元管理し、商品ごとの総合的な売上分析や在庫最適化が可能になりました。結果として、在庫回転率が改善され、機会損失が大幅に減少しています。

金融業界では、顧客データの統合によるサービス向上の事例があります。ある銀行では、口座情報、ローン情報、投資商品情報など、別々のシステムで管理されていた顧客データをETLで統合。360度の顧客ビューを確立することで、顧客ごとに最適な提案ができるようになり、クロスセルの成功率が向上しました。

製造業においては、生産設備から得られるIoTデータと受発注システムのデータを統合することで、需要予測と生産計画の精度を向上させた事例もあります。このように、ETLツールは業種を問わず、散在するデータの価値を最大化するために不可欠なテクノロジーとなっています。

データ統合により、組織は意思決定のスピードと質を大幅に改善できます。統合されたデータは、ビジネスインテリジェンスツールやAIなどと組み合わせることで、さらなる価値を生み出すことが可能です。

5-2. 業務効率化におけるETL導入の具体例

ETLツールの導入は、データ統合だけでなく、多くの企業の業務プロセスを効率化し、大幅なコスト削減と生産性向上をもたらします。ここでは、さまざまな業界でETL導入によって実現した業務効率化の具体例をご紹介します。

人事部門での活用例として、ある大手サービス企業では、採用管理システム、勤怠管理システム、給与計算システムなど複数のHRシステムからのデータ抽出と統合をETLの自動化処理で行うようになりました。これにより、月次の人事レポート作成作業が従来の5日から半日へと大幅に短縮され、人事分析の質と頻度も向上しています。

マーケティング部門においては、Web広告、SNS、メールマーケティングなど多岐にわたるデジタルマーケティングデータの統合が課題でした。ETLツールを導入したことで、キャンペーンごとのROI分析が自動化され、マーケティング担当者は週に約20時間のデータ集計作業から解放されました。その結果、クリエイティブ企画やターゲティング戦略の検討に時間を割けるようになり、コンバージョン率が向上しています。

特に中小企業では、限られたIT人材でデータ活用を進める必要があるため、専門的なプログラミングスキルがなくても利用できるETLツールの導入が業務効率化の鍵となっています。ETLによる自動化は、単純作業からの解放だけでなく、ヒューマンエラーの削減や意思決定の迅速化にも大きく貢献しています。

6. ETLツール利用時に意識するべきポイント

ETLツールを導入して運用する際には、いくつかの重要なポイントを押さえておく必要があります。データ統合基盤として企業内に定着させるためには、単に導入するだけでなく、継続的な改善と最適化が求められるためです。

まず前提として、ETLツールはデータの抽出(Extract)・変換(Transform)・ロード(Load)を効率的に行うためのものですが、本来の目的は「ビジネス価値の創出」にあります。技術的な側面だけでなく、ビジネス目標との整合性を常に意識することが重要です。

運用においては、データ量の増加に伴うパフォーマンスの問題や、ソースシステムの変更に伴う対応など、想定外の事態が発生することがあります。こうした問題に対処するためには、運用チームの体制づくりと明確な役割分担が不可欠です。

また、ETL処理は単なるデータの移動ではなく、データ品質を担保するための重要なプロセスです。特にデータガバナンスの観点から、データの整合性やセキュリティ対策にも十分な注意を払う必要があります。

6-1. ETL利用時のよくある課題と対処法

ETLツールを利用する過程では、さまざまな課題に直面することがあります。これらの問題に適切に対処することが、ETL導入の成功につながります。

データ品質の問題は、ETL利用時に最も頻繁に発生する課題の1つです。ソースデータに不備があると、それが変換後のデータにも影響を及ぼします。この対処法としては、ETLパイプラインの各段階でデータ検証ルールを設定し、異常値や欠損値を自動的に検出・修正する仕組みを構築することが効果的です。

パフォーマンスの低下も見逃せない課題です。データ量の増加に伴い、ETL処理の実行時間が長くなることがあります。この場合、増分ロードの採用や並列処理の実装、さらには処理の最適化などが有効な対策となります。特に大量データを扱う場合は、処理の分散化や効率的なリソース管理が重要です。

以下に、ETL利用時のよくある課題と効果的な対処法をまとめました。

- データソースの変更への対応:メタデータ管理とドキュメント化を徹底する

- スケジュール管理の複雑化:ワークフロー管理ツールの導入と自動化

- エラーハンドリング:詳細なログ記録と通知システムの構築

- チーム間の連携不足:明確な役割分担とコミュニケーションプロトコルの確立

- 技術的負債の蓄積:定期的なコード見直しとリファクタリング

これらの課題に対して、予防的アプローチを取ることが重要です。問題が発生してから対処するのではなく、起こりうる問題を事前に予測し、対策を講じておくことで、ETL処理の安定した運用が可能になります。

6-2. 導入後のETL活用効果を最大化するコツ

ETLツールの導入効果を最大限に引き出すためには、いくつかの重要なポイントを押さえる必要があります。単なるデータ統合ツールとしてではなく、ビジネスインテリジェンス全体の中核として位置づけることが成功への鍵です。

まず第一に、ビジネス要件と技術要件の橋渡しを意識しましょう。ETL処理の設計において、最終的なビジネス目標(売上向上、コスト削減、業務効率化など)を常に念頭に置き、それに沿った形でデータフローを構築することが重要です。技術チームとビジネス部門の定期的なミーティングやレビューを通じて、両者の認識のズレを防ぎましょう。

次に、段階的な展開と改善を心がけることです。一度に完璧なETLシステムを構築しようとするのではなく、まずは小規模な成功事例を作り、そこから徐々に拡大していくアプローチが効果的です。これにより、早期に価値を示しながら、経験を積み重ねることができます。

ETL活用の効果を最大化するための具体的なアクションとして、以下のようなものが挙げられます。

| アクション | 期待される効果 |

|---|---|

| データカタログの整備 | データの所在と意味の明確化、再利用性の向上 |

| 処理の自動化とスケジューリング | 運用コストの削減、人的ミスの防止 |

| モニタリングダッシュボードの構築 | リアルタイムでの問題検出、迅速な対応 |

| ユーザートレーニングの実施 | チーム全体のスキル向上、依存度の低減 |

| 定期的な技術アップデート | 最新機能の活用、セキュリティの維持 |

さらに、ETLツールの導入後は、定量的な効果測定を行うことも重要です。処理時間の短縮率、エラー発生率の低下、データ活用による売上貢献度など、具体的な指標を設定し、定期的に評価することで、継続的な改善につなげることができます。

最後に、外部のETLコミュニティやユーザーグループへの参加も検討しましょう。他社の事例や最新のベストプラクティスを学ぶことで、自社のETL活用をより洗練させることができます。データ活用の時代において、孤立せず常に学び続ける姿勢こそがETL導入の真の効果を引き出す秘訣です。

まとめ

ETLツール導入の最大のメリットは、散在するデータの一元管理とデータ処理の自動化による業務効率の向上です。特に中堅企業においては、限られたIT人材でも高度なデータ統合環境を構築できる点が大きな魅力となります。

導入にあたっては、自社のデータ環境や目的を明確にし、適切なツール選定を行うことが成功の鍵です。また、一度導入したら終わりではなく、継続的な改善と運用体制の整備が重要となります。

ETL導入は一朝一夕で完了するものではなく、段階的なアプローチと継続的な改善が必要です。小さな成功を積み重ねることで、組織全体のデータ活用文化を醸成していくことが、長期的な成功につながります。自社の状況に合わせた最適なETL戦略を構築し、データの持つ可能性を最大限に引き出しましょう。